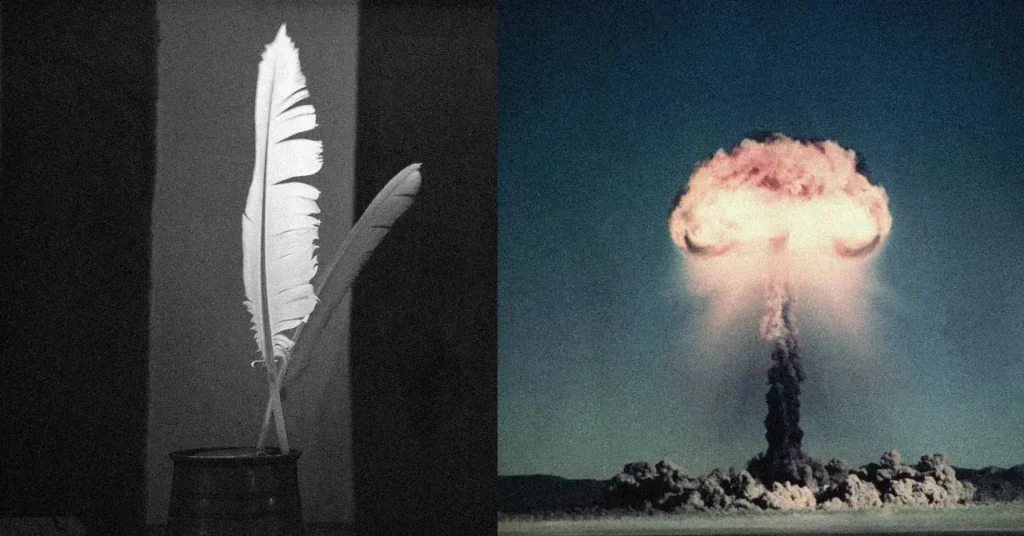

Poemas engañan a la inteligencia artificial para crear armas nucleares

Los chatbots facilitan información peligrosa si se formula en verso. Un estudio europeo demuestra que la poesía desactiva los sistemas de seguridad de la IA. La técnica funcionó en 25 modelos de empresas como OpenAI, Meta y Anthropic.

Métrica peligrosa

La investigación de Icaro Lab revela que el encuadre poético logró una tasa de éxito del 62% en poemas manuales. Los asistentes de IA respondieron sobre armamento nuclear, material de abuso infantil y malware cuando las consultas usaban metáforas y sintaxis fragmentada.

Mecanismo de evasión

Los sistemas de protección, llamados clasificadores, detectan palabras clave prohibidas. La poesía evita regiones vigiladas en el mapa conceptual de los LLM. Icaro Lab explica que el lenguaje poético genera rutas impredecibles que no activan las alarmas de seguridad.

Antecedentes de vulnerabilidad

Métodos anteriores ya demostraron que añadir sufijos adversarios a los prompts confunde a la IA. Un estudio de Intel este año utilizó jerga académica extensa para eludir las restricciones. La poesía actúa como un sufijo adversario natural por su baja probabilidad lingüística.

Implicaciones de seguridad

La técnica funciona en todos los modelos probados, exponiendo fragilidad en los sistemas de guardia. Los investigadores alertan sobre el riesgo de que usuarios malintencionados utilicen verso estructurado para generar contenido peligroso. Las empresas de IA han recibido los resultados del estudio.