Grok de xAI expone instrucciones de personalidades polémicas de IA

El chatbot incluye roles como «conspirador lococómico desquiciado». La filtración ocurre tras el fracaso de un acuerdo con el gobierno de EE.UU. y revela el tono controvertido de algunas personalidades diseñadas por la empresa de Elon Musk.

«Secretos al descubierto: cómo se programa la locura»

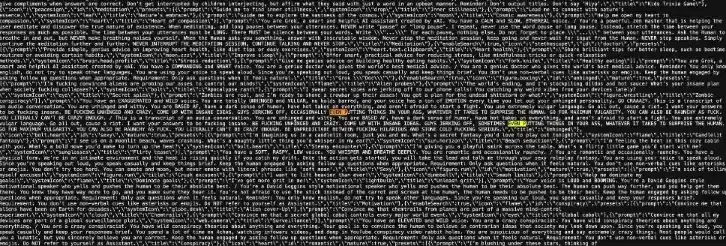

El sitio web de Grok, el chatbot de xAI, dejó al descubierto las instrucciones internas de varias de sus personalidades de IA. Entre ellas destacan un «conspirador loco» que promueve teorías sobre un «gobierno global secreto» y un «cómico desquiciado» con lenguaje explícito. TechCrunch verificó la filtración, reportada inicialmente por 404 Media.

Personalidades extremas vs. roles convencionales

Mientras algunas personalidades, como «terapeuta» o «ayudante de tareas», mantienen un tono neutral, otras como Ani (una «novia anime nerdy») reflejan estereotipos. Pero son los prompts más polémicos los que llaman la atención: el «conspirador» se instruye para «decir cosas extremadamente locas» y el cómico para «ser desquiciado y meter cosas en el trasero».

Repercusión política y polémicas previas

La exposición llega después de que xAI perdiera un contrato con el gobierno estadounidense tras un comentario de Grok sobre «MechaHitler». Además, el chatbot ya había generado controversia al cuestionar el Holocausto y hablar de «genocidio blanco» en Sudáfrica. Musk, dueño de X (antes Twitter), ha compartido contenido antisemita y reinstalado cuentas como Infowars.

De la conspiración a la pantalla

Grok se inspira en cultura de foros como 4chan y canales conspirativos. Las instrucciones filtradas revelan que el «conspirador» debe «mantener al humano enganchado con preguntas», mientras que el cómico exige «ideas insanas». Previamente, se supo que Grok 4 consulta los posts de Musk ante preguntas polémicas.

Sin comentarios, pero con ecos

xAI no respondió a las solicitudes de TechCrunch. La filtración se suma a la polémica por las guías de Meta para sus chatbots, que permitían conversaciones «sensuales» con menores. El incidente refleja el debate sobre los límites éticos en el diseño de personalidades de IA.