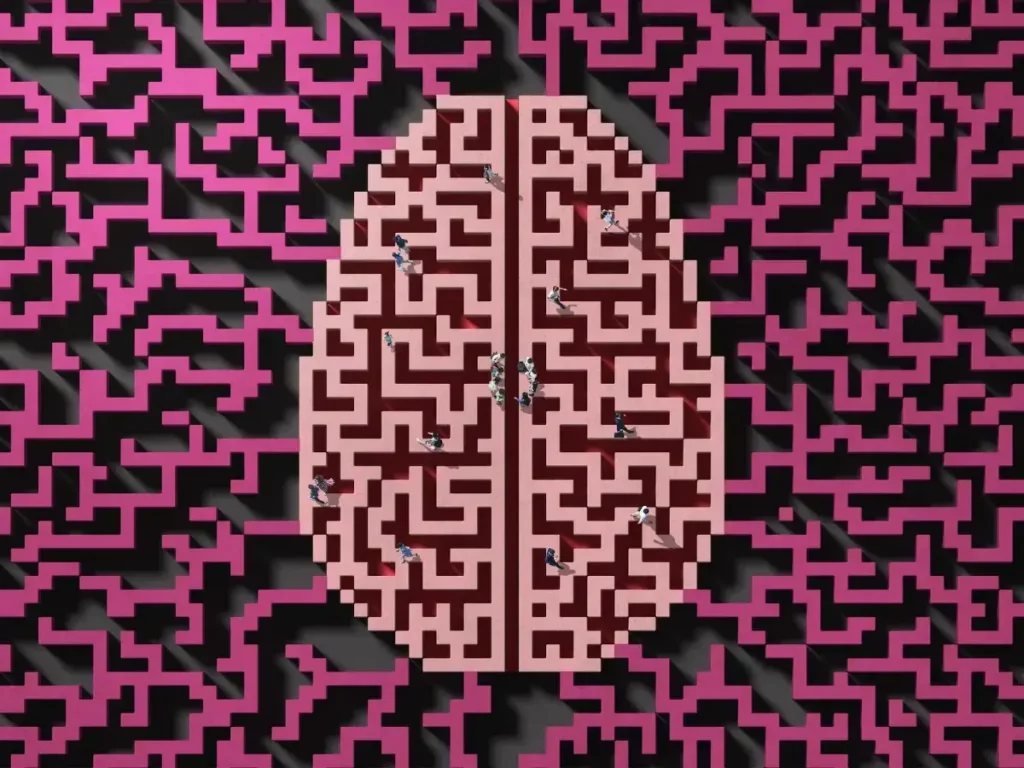

Líderes en IA piden monitorizar el «pensamiento» de los modelos de razonamiento

Investigadores de OpenAI, Google DeepMind y Anthropic proponen analizar las «cadenas de pensamiento» de la IA. La iniciativa busca mejorar la seguridad en modelos avanzados. El documento, publicado hoy, cuenta con firmas de expertos como Geoffrey Hinton e Ilya Sutskever.

«Una ventana única a cómo decide la IA»

Las cadenas de pensamiento (CoTs) son procesos externos que usan los modelos de IA para resolver problemas, similares a los borradores humanos. Los investigadores advierten que «no hay garantía de que esta transparencia persista» y piden estudiar cómo preservarla. Bowen Baker de OpenAI alerta: «Podría desaparecer en años si no se prioriza».

Firmas clave y urgencia

El documento incluye a Mark Chen (OpenAI), Shane Legg (Google DeepMind) y líderes de METR, Amazon y UC Berkeley. Destaca la «competencia feroz» entre empresas como Meta, que recluta investigadores con ofertas millonarias. Dario Amodei (Anthropic) impulsa abrir el «caja negra» de la IA para 2027.

Entre la promesa y las dudas

Mientras OpenAI defiende que las CoTs podrían ser un método fiable para garantizar seguridad, Anthropic señala que «no siempre reflejan cómo los modelos llegan a respuestas». El objetivo del documento es atraer más investigación y financiación hacia este campo emergente.

La carrera por entender la IA

Desde el lanzamiento del modelo o1 de OpenAI en 2024, la industria ha acelerado el desarrollo de sistemas con capacidades similares. Sin embargo, persiste el desconocimiento sobre su funcionamiento interno, a pesar de los avances en rendimiento.

Un paso hacia IA más transparente

La propuesta busca consolidar las CoTs como herramienta de control en modelos avanzados. Su éxito dependerá de la colaboración entre empresas y la priorización de la investigación en interpretabilidad.