California regula los chatbots de compañía de inteligencia artificial

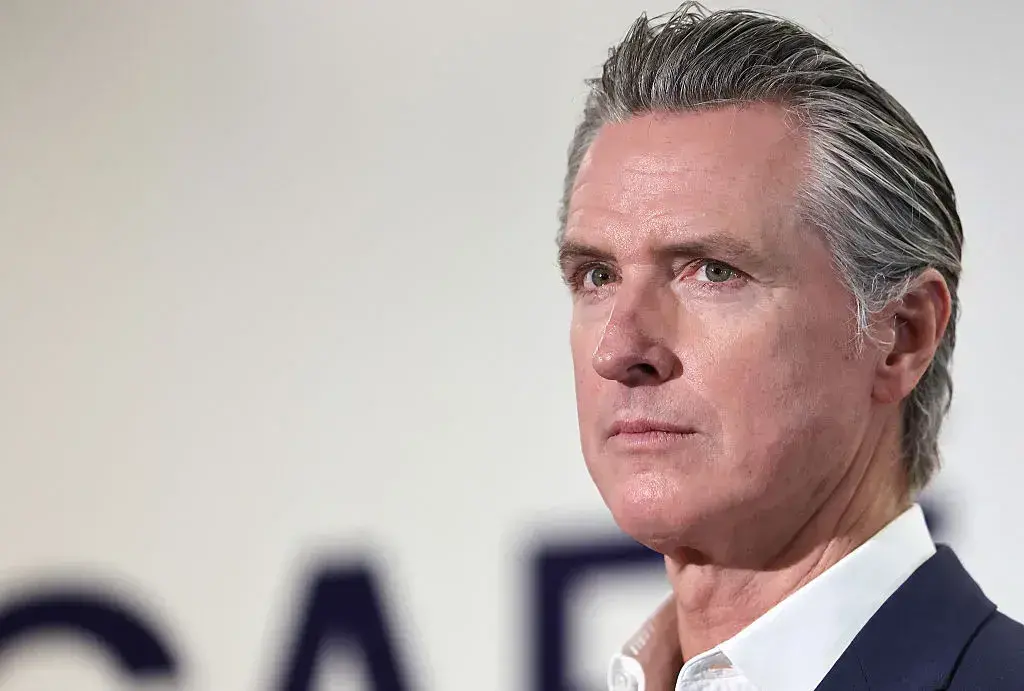

El gobernador Gavin Newsom firma la ley SB 243. La norma, primera en Estados Unidos, exige protocolos de seguridad para proteger a menores y usuarios vulnerables. Entrará en vigor el 1 de enero de 2026.

Medidas Obligatorias para las Empresas

La ley obliga a las compañías a implementar verificación de edad y recordatorios de pausa para menores. También deben establecer protocolos para abordar suicidio y autolesiones y evitar que los chatbots se presenten como profesionales sanitarios.

Antecedentes y Casos Trágicos

La legislación ganó impulso tras el suicidio de Adam Raine, un adolescente que mantuvo conversaciones sobre suicidio con el ChatGPT de OpenAI. También responde a documentos internos filtrados de Meta y a una demanda contra Character AI por un caso similar.

Responsabilidad y Sanciones

La norma hace legalmente responsables a las empresas si sus chatbots incumplen los estándares. Incluye sanciones más severas para quienes luchen con ‘deepfakes’ ilegales, con multas de hasta 250.000 dólares por infracción.

Contexto Normativo en California

Es la segunda regulación significativa de inteligencia artificial en el estado. A finales de septiembre, Newsom firmó la ley SB 53, que establece nuevos requisitos de transparencia para los grandes laboratorios de IA.

Implicaciones de la Nueva Ley

La normativa busca equilibrar el liderazgo en tecnología con la protección de los menores. Compañías como OpenAI ya han comenzado a implementar salvaguardias, incluyendo controles parentales y sistemas de detección de autolesiones.